Observatoire

Coup d’œil : quelles sont les nouvelles tendances en matière de politique numérique ?

Géopolitique

Le Gouvernement américain a annoncé son intention (voir : décret) d’interdire ou de restreindre ses investissements en Chine dans trois secteurs industriels – les semi-conducteurs, les technologies quantiques et les systèmes d’IA (spécifiques) – tandis que les autorités de régulation chinoises n’ont pas approuvé le projet d’Intel d’acquérir le fabricant de puces israélien Tower Semiconductor. La Ville de New York a adopté l’interdiction d’installer TikTok sur les appareils appartenant au Gouvernement.

Gouvernance de l’IA

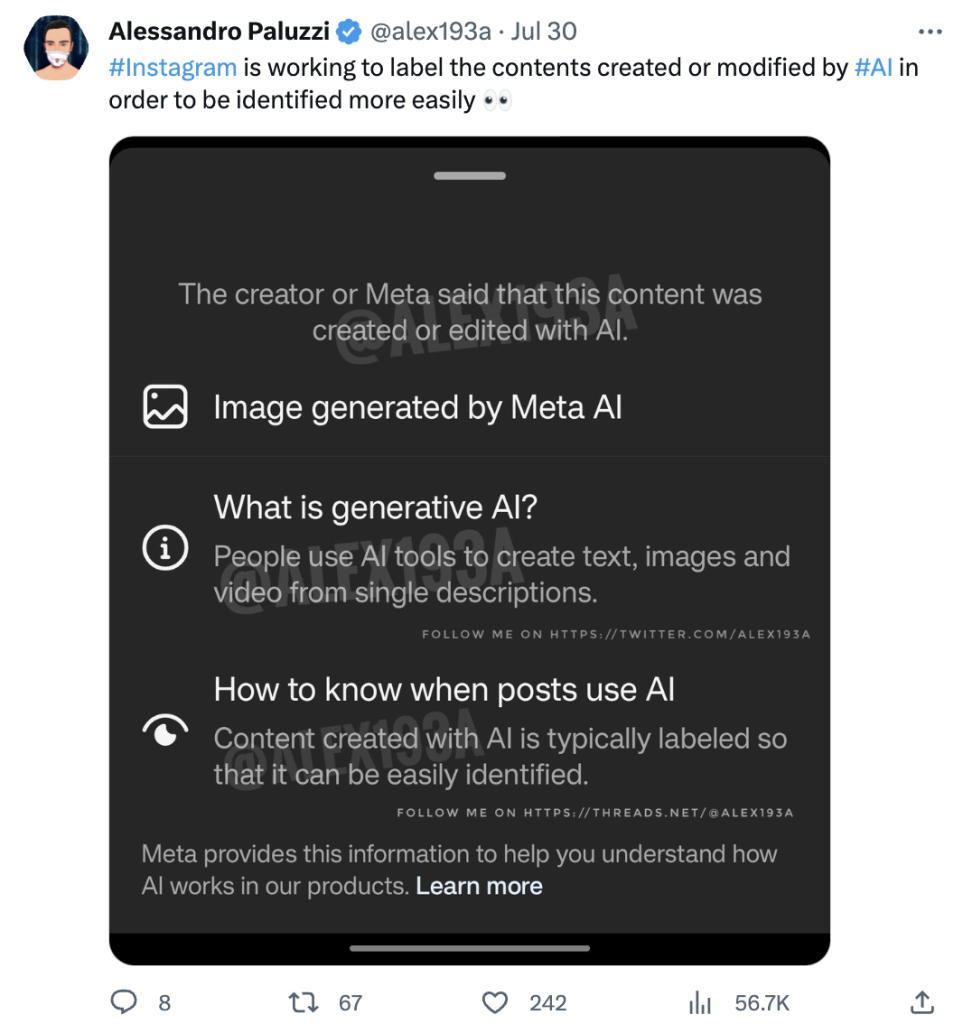

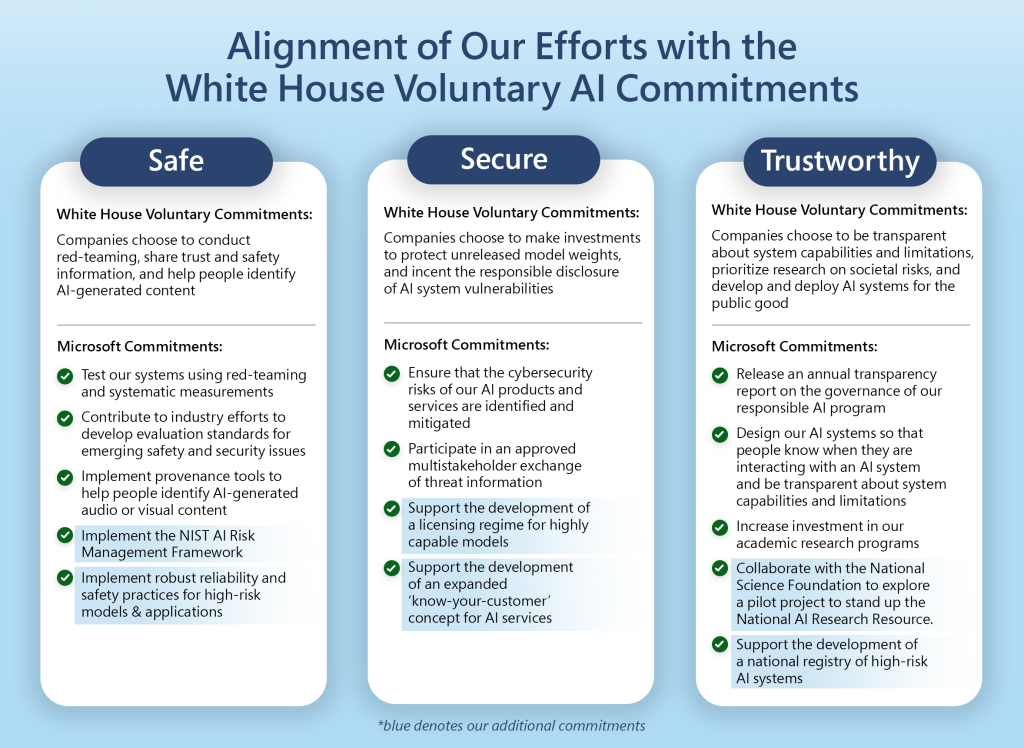

Quatre entreprises développant l’IA – Anthropic, Google, Microsoft et OpenAI – ont lancé un nouveau corps de métier spécialisé dans le développement sûr et responsable de modèles d’IA d’avant-garde. Dans le même temps, des dizaines de grandes entreprises se sont empressées de bloquer GPTBot, le nouveau robot d’exploration d’OpenAI qui recueille des données pour alimenter ChatGPT.

Les députés britanniques exhortent le Gouvernement à instaurer de nouvelles règles en matière d’IA d’ici à la fin de l’année, faute de quoi ils risquent d’être distancés. Les pays du groupe BRICS (Brésil, Russie, Inde, Chine et Afrique du Sud) ont créé un groupe chargé d’étudier les cadres et les normes de gouvernance de l’IA, et de contribuer à rendre ses technologies « plus sûres, plus fiables, plus contrôlables et plus équitables ». Le projet de code de pratique du Canada pour la réglementation de l’IA générative est mis à la disposition du public.

Les autorités chargées de la protection des données ont exprimé leur inquiétude quant aux pratiques des entreprises technologiques en matière de récupération de données (ou de sites web) et aux conséquences pour les données personnelles. Ce n’est pas parce que des informations sont accessibles au public sur l’Internet que les protections de la vie privée ne s’appliquent plus, précise la déclaration.

Sécurité

Le sixième cycle de négociations des Nations unies sur un nouveau traité relatif à la cybercriminalité s’est achevé à New York sans progrès notable.

Le logiciel malveillant Qakbot, qui a infecté plus de 700 000 appareils, a été neutralisé par une opération des services répressifs réunissant les États-Unis, la France, l’Allemagne, les Pays-Bas, le Royaume-Uni, la Roumanie et la Lettonie. Meta a supprimé des milliers de comptes et de pages liés à Spamouflage, qu’il décrit comme la plus grande opération d’influence secrète connue au monde. La société de sécurité NCC Group a signalé un nombre record d’attaques par rançongiciel en juillet, qu’elle attribue à l’exploitation d’une vulnérabilité dans MOVEit, un logiciel de transfert de fichiers, par un groupe de pirates informatiques connu sous le nom de CLOP ou Cl0p.

Au Royaume-Uni, des vidéos partagées sur TikTok et Snapchat encourageant les individus à voler dans les magasins ont provoqué une forte agitation et plusieurs arrestations dans Oxford Street, à Londres.

Les autorités américaines chargées de la sécurité et de la normalisation demandent instamment aux organisations, en particulier celles qui soutiennent les infrastructures critiques, d’envisager la migration vers des normes cryptographiques post-quantiques en prévision de cyberattaques utilisant la puissance quantique.

Infrastructure

Il faudra du temps pour que la connexion internet de l’Afrique soit totalement rétablie après qu’un glissement de terrain sous-marin dans le canyon du Congo a endommagé deux câbles sous-marins importants qui longent la côte occidentale de l’Afrique.

Économie de l’Internet

Le 25 août, des réglementations plus rigoureuses pour les très grandes plateformes en ligne et les moteurs de recherche sont entrées en vigueur dans le cadre de la nouvelle loi sur les services numériques de l’UE. La Commission européenne a engagé une procédure formelle à l’encontre de Microsoft pour avoir intégré le logiciel de communication Teams à Office 365. Quelques semaines plus tard, Microsoft a annoncé qu’elle dégrouperait ses logiciels pour les clients européens et suisses à partir du mois d’octobre.

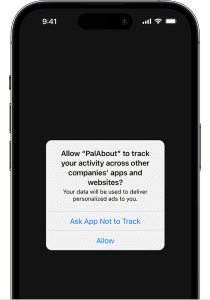

L’autorité française de la concurrence enquête sur Apple pour un possible comportement discriminatoire. Les annonceurs affirment que la société leur a imposé sa politique de transparence en matière de suivi des applications (App Tracking Transparency – ATT), mais s’est exemptée des mêmes règles.

Microsoft a accepté de transférer à Ubisoft les droits de licence pour la diffusion en nuage des jeux d’Activision Blizzard, afin d’obtenir l’approbation du Royaume-Uni pour l’acquisition d’Activision. La Commission européenne devra réévaluer son approbation préalable.

Droits numériques

Le projet Worldcoin relancé par Sam Altman, qui comprend une cryptomonnaie et un réseau d’identité, a attiré l’attention des régulateurs de la vie privée en raison d’éventuelles irrégularités liées à ses méthodes de collecte de données biométriques. Les conditions d’utilisation révisées de Zoom ont suscité la controverse en raison de l’intention de l’entreprise d’utiliser les données des clients pour l’apprentissage automatique et l’IA. Elle a par la suite clarifié sa position.

L’autorité norvégienne de protection des données a imposé des amendes journalières d’un million de couronnes (98 500 USD) à Meta pour non-respect de l’interdiction du ciblage commercial basé sur le comportement par Facebook et Instagram. OpenAI fait l’objet d’une enquête en Pologne : un chercheur a affirmé que l’entreprise avait traité ses données « de manière illégale, déloyale et non transparente ».

Politique de contenu

L’administration chinoise du cyberespace a publié un projet de directives pour l’introduction d’un logiciel de gestion du temps d’écran afin d’endiguer le problème d’addiction aux téléphones intelligents chez les mineurs.

Le Canada a critiqué Meta pour avoir banni les informations nationales de ses plateformes alors que des incendies de forêt ravageaient certaines régions du pays. Il demande à Google et à Meta de contribuer à hauteur d’au moins 230 millions de dollars canadiens (157 millions d’euros) au soutien des médias locaux.

Développement

Les projets d’identité numérique se multiplient dans le monde entier. L’ Australie prévoit de nouvelles règles pour son identification numérique soutenue par le Gouvernement fédéral d’ici l’année prochaine. Le Gouvernement américain souhaite collaborer avec le secteur privé afin de développer des normes de téléphonie mobile pour l’identification numérique, à l’instar de ce que les Philippines envisagent de faire. Le Nigeria reçoit l’aide de la Banque mondiale pour mettre en place des cartes d’identité numériques à l’échelle nationale.

LES CONVERSATIONS DE LA VILLE – GENÈVE

Le Colloque mondial sur les indicateurs des télécommunications / TIC (WTIS) de cette année (3-4 juillet) s’est penché sur les moyens de mesurer les données pour faire progresser la connectivité universelle à l’Internet et a examiné les résultats de deux groupes d’experts qui ont réaffirmé l’importance de disposer de données comparables au niveau international pour suivre les évolutions liées aux TIC. L’UIT, en collaboration avec l’UE, a lancé le projet « Dashboard for Universal and Meaningful Connectivity » (tableau de bord pour une connectivité universelle et significative) afin de suivre les progrès et les performances des pays.

Lors du Sommet mondial AI for Good (6-7 juillet), plus de 280 projets ont présenté les capacités de l’IA à faire progresser les ODD et à répondre aux besoins urgents du monde, dans le cadre de discussions sur les politiques et les réglementations en matière d’IA, et sur l’évolution future de l’IA.

Le Conseil de l’UIT a réuni ses 48 pays membres pour examiner les perspectives stratégiques de l’UIT. Lors du Conseil de cette année (11-21 juillet), la secrétaire générale, Doreen Bogdan-Martin, a mis en avant deux objectifs principaux pour l’UIT : la connectivité universelle et la transformation numérique durable. Le Conseil a noté que les questions numériques occupent une place de plus en plus importante dans les programmes mondiaux, notamment lors du prochain Sommet sur les objectifs du Millénaire pour le développement (2023) et du Sommet de l’avenir (2024).

En bref

IA et droits d’auteur : les États-Unis et le Royaume-Uni envisagent de nouvelles mesures

Si vous utilisez le travail de quelqu’un d’autre, vous avez alors besoin d’une autorisation. Cela résume la façon dont le monde a essentiellement abordé les droits des auteurs – jusqu’à présent.

L’ arrivée de modèles d’IA générative, comme ChatGPT, a bouleversé les règles du droit d’auteur. Tout d’abord, les modèles qui alimentent l’IA générative sont formés à partir de toutes les données qu’ils parviennent à se procurer, qu’il s’agisse ou non de contenus protégés par le droit d’auteur. Les auteurs et les artistes mécontents souhaitent que cette pratique cesse. Pour eux, la notion d’utilisation équitable ne suffit pas, surtout si des entreprises gagnent de l’argent grâce à ce système.

Mais il y a un autre problème : les utilisateurs qui coécrivent de nouveaux contenus avec l’aide de l’IA demandent la protection du droit d’auteur pour leurs œuvres. Le droit d’auteur étant attaché à la paternité de l’œuvre, les organismes de réglementation de la propriété intellectuelle sont confrontés à un dilemme : quelles parties doivent être protégées par le droit d’auteur, et où doit se situer la limite ?

Confrontées à ces questions, les agences de la propriété intellectuelle du Royaume-Uni et des États-Unis ont lancé des procédures de consultation pour les aider à définir les prochaines démarches à entreprendre. Tous deux ont reconnu que de nouvelles règles pourraient être nécessaires.

L’action du Royaume-Uni. En juin, l’agence britannique de la propriété intellectuelle a formé un groupe de travail chargé d’élaborer un code de pratique à caractère facultatif. Microsoft, DeepMind et Stability AI figurent parmi les membres du groupe de travail, ainsi que des représentants de groupes artistiques et de recherche.

Le Gouvernement souhaite que le groupe élabore un guide de bonnes pratiques pour « … aider les entreprises d’IA à accéder à des œuvres protégées par le droit d’auteur pour alimenter leurs modèles, tout en veillant à ce que les résultats générés soient protégés (par exemple par un étiquetage) afin de soutenir les auteurs d’œuvres protégées par le droit d’auteur ». Le Gouvernement a clairement indiqué que s’il n’y avait pas d’accord ou si le guide n’était pas adopté, il pourrait légiférer.

Les questions de droits d’auteur figurent également parmi les principaux défis que le Gouvernement britannique doit relever dans le cadre de sa lutte contre la gouvernance de l’IA.

L’action des États-Unis. L’agence américaine du droit d’auteur (US Copyright Office) a lancé un appel à contributions pour recueillir les commentaires du public sur les mesures réglementaires possibles ou les nouvelles règles nécessaires pour réguler ces pratiques. Il s’agit généralement de la dernière étape avant que de nouvelles mesures ou règles ne soient proposées, et nous pourrions donc être amenés à examiner des propositions de nouvelle législation avant la fin de l’année.

Les questions sur lesquelles se penche l’agence des droits d’auteur sont assez précises. Premièrement, elle souhaite comprendre comment les modèles d’IA utilisent, et devraient utiliser, des données protégées par le droit d’auteur dans leurs mécanismes d’apprentissage. Deuxièmement, elle souhaite recevoir des propositions sur la manière dont le contenu généré par l’IA pourrait être protégé par le droit d’auteur. Troisièmement, elle entend déterminer comment la responsabilité en matière de droit d’auteur fonctionnerait dans le contexte du contenu généré par l’IA. Quatrièmement, elle sollicite des commentaires sur la violation potentielle des droits de publication, c’est-à-dire les droits des individus à contrôler l’utilisation commerciale de leur image ou de leurs informations personnelles.

Sujet tabou. Et pourtant, rien ne permet de penser que ces consultations aborderont – et encore moins résoudront – la manière d’inverser les dommages déjà causés. Les contenus protégés par le droit d’auteur font désormais partie de cette masse énorme de données sur laquelle les modèles ont été entraînés, ainsi que des contenus générés par les robots d’intelligence artificielle. En outre, si l’intervention humaine est nécessaire pour déclencher la protection du droit d’auteur (comme l’indiquent les dernières orientations des États-Unis, par exemple), qu’en est-il des résultats de l’IA qui intègrent des contenus protégés par le droit d’auteur dans une proportion inquiétante ?

Solutions provisoires. Dans l’intervalle, les entreprises à l’origine de puissants modèles de langage (les modèles qui forment les outils d’IA générative) pourraient être amenées à faire davantage pour s’assurer que les contenus protégés par le droit d’auteur ne sont pas utilisés. L’une des solutions pourrait consister à mettre en œuvre des mécanismes automatisés qui détectent les œuvres protégées par le droit d’auteur dans le contenu destiné à être utilisé dans les processus de formation ou de génération, et à supprimer cette partie des données avant le début du processus de formation. Par exemple, les robots de recherche (que les sites web peuvent limiter ou désactiver) pourraient être incapables d’extraire du contenu protégé par le droit d’auteur grâce à un codage adéquat.

Une autre solution – probablement plus attrayante pour les entreprises – consiste à trouver de nouveaux moyens, tels que l’octroi de licences, pour monétiser le processus de manière que les auteurs et le secteur de l’IA puissent en bénéficier. Il s’agit là d’une solution gagnant-gagnant.

Qui est Zarya de l’Aube, le personnage qui fait notre couverture ?

Zarya est la protagoniste d’une courte bande dessinée écrite par Kris Kashtanova et illustrée par Midjourney, un générateur d’images basé sur l’IA. En septembre 2022, Kashtanova a sollicité la protection des droits d’auteur pour la bande dessinée auprès de l’Institut américain des droits d’auteur sans révéler que Midjourney était impliqué dans la création des illustrations. Le droit d’auteur a d’abord été accordé, mais l’Institut des droits d’auteur a ensuite révoqué la protection de l’œuvre d’art. Il a expliqué que seules les œuvres créées par un être humain peuvent être protégées. Dans ce cas, la mise en page, le texte et l’intrigue du livre pouvaient bénéficier d’une protection, mais pas les images elles-mêmes.

Cette affaire constitue un précédent important pour l’application de la législation sur le droit d’auteur aux œuvres générées par l’IA. La décision de l’Institut du droit d’auteur confirme que les êtres humains doivent avoir le contrôle de la production, même lorsqu’un ordinateur est impliqué dans le processus créatif. En comparaison, « au lieu d’être un outil que Mme Kashtanova contrôlait et guidait pour obtenir l’image qu’elle souhaitait, Midjourney génère des images de manière imprévisible. En conséquence, les utilisateurs de Midjourney ne sont pas les “auteurs”, aux fins du droit d’auteur, des images générées par la technologie ».

« L’effet Bruxelles » : le DSA et le cadre transatlantique de protection des données personnelles entrent en vigueur

Lorsqu’une ville devient synonyme de prouesse en matière d’élaboration de règles, ses législateurs savent qu’ils font quelque chose de bien. Telle est la renommée mondiale de Bruxelles, qui abrite les principales institutions de l’Union européenne.

Au cours des dernières semaines, deux nouveaux ensembles de règles sont entrés en vigueur, qui, avec le RGPD, établissent de nouvelles normes en matière de respect des droits des utilisateurs et de réglementation du marché. Tous deux sont susceptibles d’influencer les pratiques et les mesures dans d’autres pays, ce qui témoigne de l’influence de « l’effet Bruxelles » (un concept inventé par un professeur de droit de Columbia, semble-t-il).

Le premier. Le règlement européen sur les services numériques (DSA) vient de démarrer la mise en œuvre de mesures strictes sur 19 très grandes plateformes en ligne et moteurs de recherche. Ces mesures vont de l’obligation d’étiqueter toutes les publicités et d’informer les utilisateurs de l’identité de leurs auteurs à la possibilité pour les utilisateurs de désactiver les recommandations de contenu personnalisées. Comme pour le RGPD, l’impact du DSA s’étend au-delà des frontières de l’UE. Toute entreprise au service d’utilisateurs européens, quel que soit son lieu d’implantation, sera soumise à ces nouvelles règles. Il est intéressant de noter que parmi ces 19 entreprises majeures, seules deux sont basées en Europe : Booking.com, dont le siège se trouve aux Pays-Bas, et Zalando, dont le siège se trouve en Allemagne. Les autres sont principalement originaires des États américains de Californie et de Washington (soit 15 d’entre elles), et les deux autres (Alibaba et TikTok) sont des entreprises chinoises.

Le second. Le cadre transatlantique de protection des données (TADPF) récemment adopté par l’Union européenne et les États-Unis garantit que les données personnelles des citoyens européens qui traversent l’Atlantique bénéficient du même niveau de protection aux États-Unis qu’au sein de l’Union européenne. Même la Cour de justice de l’UE contribue à « l’effet Bruxelles » : avant le TADPF, la Cour a invalidé deux versions antérieures de cadres transatlantiques – le Safe Harbor Act et le Privacy Shield –, renvoyant à chaque fois les décideurs politiques à leur propre réflexion sur la manière de faire correspondre la législation américaine aux normes de l’UE.

Respecté. Le RGPD, qui a été la première loi à donner son éponyme à la capitale belge, a fait des émules dans d’autres pays (ce que l’on appelle l’effet Bruxelles de droit). La loi chinoise sur la protection des informations personnelles (PIPL), par exemple, a été fortement influencée par le RGPD, avec des dispositions sur la collecte, le stockage et l’utilisation des données qui reflètent celles de la législation de l’UE.

Peur de manquer quelque chose. Mais « l’effet Bruxelles » est également redouté par d’autres. Dans la course à la réglementation des technologies émergentes, telles que l’IA, les pays rivalisent pour arriver les premiers, de peur d’être distancés par d’autres législations. Les députés britanniques se sont montrés particulièrement inquiets et ont insisté auprès du Gouvernement pour qu’il accélère les choses : nous pensons que si le Royaume-Uni n’introduit pas de nouvelle réglementation statutaire pendant trois ans, les bonnes intentions du Gouvernement risquent d’être dépassées par d’autres législations – comme la loi européenne sur l’IA –, qui pourraient devenir la norme de facto et être difficiles à supplanter.

L’UE a dû payer le prix de son influence en matière d’élaboration de règles, car les entreprises sont souvent très critiques à l’égard des réglementations européennes, qui sont comparativement très strictes, et l’accusent de manquer de prouesses technologiques et d’un avantage concurrentiel. Mais il s’agit d’un risque stratégiquement calculé de la part de l’UE : Bruxelles ne sait que trop bien que son pouvoir réglementaire ne peut pas être facilement limité ou déplacé.

Sans conducteur : l’avenir des taxis autonomes

La révolution de la voiture sans conducteur s’installe à San Francisco. Des centaines de voitures autonomes, appartenant principalement à Waymo, de Google, Cruise, de General Motors, Uber et Lyft, peuvent désormais être aperçues régulièrement dans les rues de la ville.

L’essor des véhicules sans conducteur intervient après que la California Public Utilities Commission, une agence de l’État, a voté le 11 août pour autoriser Waymo et Cruise à prendre des passagers payants de jour comme de nuit dans tout San Francisco.

Forte opposition. Avant le vote, la California Public Utilities Commission a dû faire face à une vive opposition de la part des habitants et des services municipaux. Les organismes chargés des transports et de la sécurité, tels que la police et les pompiers, ainsi que les habitants de la Californie, se sont opposés à l’extension des services de taxis autonomes payants pour des raisons de sécurité. Les manifestants sont descendus dans la rue non seulement pour souligner les problèmes de sécurité, mais aussi parce que les voitures affectaient les ressources nécessaires au bon fonctionnement des transports publics, par exemple en bloquant une voie très fréquentée ou en provoquant des embouteillages par des manœuvres imprévisibles.

Accident de voiture. Quelques jours plus tard, des rapports faisant état de multiples accidents dans la ville ont contraint le California Department of Motor Vehicles (DMV) à ordonner à General Motors de réduire le nombre de véhicules Cruise actifs. Les habitants et les services municipaux ont eu raison de s’inquiéter pour la sécurité, mais la décision du DMV n’a pas suffi à apaiser les craintes. Les manifestations se poursuivent.

Problèmes de démarrage ? Toute technologie émergente connaît des problèmes de démarrage. Cela devient critique lorsque ces problèmes menacent la vie humaine. Heureusement, les passagers impliqués directement dans ces accidents n’ont subi que des blessures ne mettant pas leur vie en danger (l’affirmation selon laquelle deux véhicules Cruise ayant bloqué par inadvertance une ambulance auraient contribué à un retard fatal dans le transfert du piéton à l’hôpital, a été réfutée par la société).Toutefois, cela soulève une question qui donne à réfléchir : et si les accidents de véhicules autonomes étaient plus graves ? Le spectre des accidents mortels, rappelant l’incident de Tesla en 2016, se profile comme un rappel obsédant des défis et des responsabilités associés au développement de la technologie de conduite autonome – et du fait que rien ne garantit que des accidents de voiture mortels ne se reproduiront pas. Il est fort probable qu’ils se répètent.

Source : Safe Street Rebel

Pas d’effet de masse. Tant que les taxis autonomes n’auront pas gagné la confiance des citoyens, leur adoption sera relativement limitée. Il ne s’agit pas d’acheter un appareil électroménager après avoir lu des critiques élogieuses ou de s’inscrire sur une nouvelle plateforme de médias sociaux parce que la moitié du monde y est déjà inscrite.

Les préoccupations en matière de sécurité constituent une entrave importante qui pourrait freiner les personnes et inciter les conducteurs potentiels à réfléchir à deux fois (voire trois fois) avant de mettre leur vie entre les mains d’une voiture sans conducteur. La question est la suivante : que faudra-t-il aux taxis autonomes pour gagner – ou perdre définitivement – la confiance du public ?

PayPal va là où l’on craignait que Libra ne s’aventure

Quatre ans se sont écoulés depuis que Facebook (aujourd’hui Meta) a annoncé le lancement de sa monnaie numérique, Libra. À l’époque, l’entreprise était embourbée dans des scandales liés à la confidentialité des données, ce qui a scellé le destin du projet avant même qu’il n’ait eu le temps de prendre son envol.

Avance rapide. PayPal vient d’annoncer un nouveau projet : PayPal dollar, une monnaie stable (l’équivalent numérique des monnaies fiduciaires comme le dollar américain, l’euro et d’autres) qui est très similaire à ce que Facebook avait en tête avec Libra.

Comment ça marche. Les prévisions de PayPal pour sa nouvelle monnaie stable remontent à 2020. Créé par Paxos, une société technologique privée spécialisée dans les monnaies stables, PayPal USD (PYUSD) a été lancé il y a quelques semaines sur la plateforme d’échange (blockchain) Ethereum. La valeur des monnaies stables est directement liée à une monnaie fiduciaire sous-jacente, généralement le dollar américain ; dans le cas présent, chaque pièce PayPal dollar est garantie à un taux de 1:1 avec le dollar américain détenu sur des comptes de réserve gérés par Paxos et d’autres dépositaires.

Au cœur d’une surveillance plus stricte. Malgré sa position, PayPal opère sur un marché où la réglementation est plus stricte. En novembre, FTX, qui était alors l’une des plus grandes bourses de cryptomonnaies au monde, a fait faillite. Dans le même ordre d’idées, Paxos a reçu l’ordre de cesser d’émettre des BUSD, la monnaie stable développée par Binance, la plus grande Bourse de cryptomonnaies au monde. À bien des égards, PYUSD fonctionne de manière très similaire à BUSD (paiements instantanés et faibles frais).

Des perspectives renforcées. Quelques différences fondamentales distinguent PayPal et sa monnaie stable. Tout d’abord, PayPal jouit d’une meilleure réputation dans le secteur financier que Facebook et Binance n’auraient jamais pu l’espérer. Deuxièmement, les décideurs politiques sont aujourd’hui plus conscients du fonctionnement des monnaies stables et de leurs avantages (et défis). Par exemple, le fait que les monnaies stables ne soient pas aussi vulnérables que les cryptomonnaies en fait une option beaucoup plus sûre. PayPal est à jour en ce qui concerne les exigences relatives à la connaissance du client, et son code source ouvert permet à quiconque de le consulter. Les chances sont en faveur de PayPal.

Pourtant, PayPal ne doit pas considérer ce moment décisif comme acquis. Il peut soit contribuer à la méfiance croissante des régulateurs à l’égard des cryptomonnaies, soit montrer que les monnaies stables – la forme la plus populaire de cryptomonnaie – sont l’avenir des paiements numériques.

Actualités de la Francophonie

Proposition de contenus pour les deux pages « Actualités de la Francophonie » de la revue en français Digital Watch de septembre 2023 / n°82

Lancement des rencontres bimensuelles sur l’actualité de la gouvernance du numérique pour les délégations francophones auprès des Nations Unies à New York

Les enjeux liés aux développements technologiques occupent une place centrale dans l’agenda des Nations Unies. À New York, le numérique est devenu un sujet transversal des principaux organes onusiens, et sa transversalité s’est également révélée dans les travaux des six Commissions de l’Assemblée générale des Nations Unies, qui l’abordent sous différents angles. La Première Commission s’intéresse aux implications sécuritaires du numérique en consacrant un pan important de ses travaux aux questions de cybersécurité. La Deuxième Commission l’examine sous le prisme du Programme 2030, formulant des recommandations visant à orienter le potentiel du numérique vers la mise en œuvre des Objectifs de développement durable. Ses implications en matière de droits de l’Homme sont examinées par la Troisième Commission tandis que la Quatrième Commission travaille sur le rôle des technologies numériques dans l’action de communication des Nations Unies, dans la lutte contre les discours haineux et la désinformation, de même que dans la réalisation des mandats confiés aux opérations de maintien de la paix. Le numérique n’échappe pas aux travaux de la Cinquième Commission en raison des implications budgétaires de la transformation numérique des Nations Unies. Les enjeux relatifs à la réglementation internationale du numérique font partie intégrante des travaux de la Sixième Commission.

La publication du rapport du Secrétaire général de l’ONU «Notre Programme Commun» (septembre 2021) a parallèlement donné le coup d’envoi à de multiples processus intergouvernementaux et multipartites qui abordent de manière spécifique la question du numérique dans le cadre des consultations qui jalonnent l’élaboration d’un Pacte numérique mondial et d’un Code de conduite pour l’intégrité de l’information sur les plateformes numériques. Ainsi, un chapitre de «Notre Programme Commun » est au centre des discussions intergouvernementales: les «Nations Unies 2.0», ambitieux projet pour faire, comme son nom l’indique, des innovations numériques un vecteur de modernisation des Nations Unies. Le numérique est donc omniprésent dans le travail des diplomates à New York et le sera davantage à mesure que la transition numérique engendrera de nouveaux défis et des opportunités inédites pour la paix, le développement et les droits humains.

Malgré cette importance croissante, la participation des diplomates francophones aux processus consacrés aux enjeux numériques demeure assez faible à New York, en particulier ceux des pays en développement. Faute de ressources humaines suffisamment formées à ces enjeux au sein des Missions permanentes, la question du numérique semble réservée aux experts de Genève ainsi qu’aux spécialistes dépêchés ponctuellement par les capitales pour suivre des sessions spéciales. Les intérêts des États membres de l’Organisation internationale de la Francophonie (OIF) pourraient pâtir de cette absence dans les sessions de discussion et de négociation qui se tiennent à New York, d’où la nécessité de renforcer la sensibilisation de leurs représentants sur les implications diplomatiques des développements numériques.

À cette fin, à travers sa Représentation auprès des Nations Unies à New York (RPNY) et sa Direction de la Francophonie économique et numérique (DFEN), l’OIF a mis en place un « Café numérique francophone » à l’intention des délégations des pays francophones.

Dans un cadre informel et sur une base régulière (bimensuelle), cette initiative consiste à réunir les experts francophones à la RPNY pour échanger durant une heure trente sur l’actualité de la coopération numérique et faire le point sur les processus des Nations Unies dédiés au numérique en vue de :

- soutenir l’appropriation des défis et opportunités diplomatiques liés aux développements du numérique et de l’intelligence artificielle ;

- informer sur les processus multilatéraux consacrés aux enjeux du numérique avec un accent particulier sur les sujets les plus pertinents par rapport à l’agenda des Nations Unies à New York ;

- encourager le dialogue et la concertation sur les points à l’agenda des instances qui traitent des divers aspects des technologies numériques en vue du développement des positions communes.

La finalité est de bâtir une communauté diplomatique francophone informée, formée et organisée pour défendre aux mieux ses intérêts et appuyer le plaidoyer de la Francophonie dans les discussions intergouvernementales sur le numérique.

S’inscrivant dans le cadre du volet « Gouvernance du numérique » du projet D-CLIC de l’OIF, la première session du Café numérique francophone s’est tenue le 6 juillet 2023. Elle a été consacrée à la Contribution de la Francophonie au Pacte numérique mondial. Remise en main propre à New York, le 3 mai 2023, à l’Envoyé pour les technologies du Secrétaire général des Nations Unies, M. Amandeep Singh Gill, cette contribution positionne l’espace francophone sur les grands enjeux de la discussion internationale sur la gouvernance du numérique et met l’accent sur deux défis de taille : le renforcement des capacités numériques comme composante indispensable pour réaliser la connectivité universelle et réduire la fracture numérique d’une part, et la défense de la diversité culturelle et linguistique dans l’espace numérique à travers un plaidoyer robuste en faveur de la « découvrabilité » des contenus en ligne d’autre part.

En savoir plus : www.francophonie.org

Une troisième cohorte de fonctionnaires et diplomates bénéficie d’une formation en ligne en français sur la gouvernance de l’Internet

À l’issue d’un appel ayant suscité plus de 300 candidatures, les 26 fonctionnaires et diplomates de 18 des Etats et gouvernements membres de l’OIF sélectionnés suivront à partir du 14 septembre un cycle de formation en ligne de 10 semaines sur l’Introduction à la gouvernance de l’Internet. Cette formation s’inscrit dans la lignée des 2 formations pilotes du projet « D-CLIC, formez-vous au numérique avec l’OIF », précédemment soutenues par l’OIF en 2022 et dispensées en français par la DiploFoundation. Afin de capitaliser sur ces actions, de toucher davantage d’agents publics francophones et d’en faire un cycle de formation de long terme, l’OIF a souhaité appuyer en 2023 l’Université Senghor pour déployer cette nouvelle activité de renforcement de capacités. Cette troisième session sera donc dispensée par cette université située à Alexandrie, opérateur direct de la Francophonie, dont la mission est de former, en français, des cadres capables de relever les défis du développement durable en Afrique et en Haïti.

À cet égard, la gouvernance de l’Internet (GI) est de plus en plus prépondérante dans le travail des diplomates et des fonctionnaires nationaux. Ce cycle de formation en français qui mobilise un minimum de 6 à 8 heures d’étude par semaine en présente les enjeux stratégiques et opérationnels pour les pays en couvrant des questions centrales, notamment : l’infrastructure et la normalisation, la cybersécurité, les questions juridiques, économiques, de développement et socioculturelles, les droits de l’Homme, ainsi que les processus et les acteurs de la GI.

À travers ce cycle de formation, l’OIF vise ainsi à renforcer les compétences des fonctionnaires et diplomates francophones afin de leur permettre de mieux apprécier les défis actuels et futurs de la gouvernance numérique. Les bénéficiaires de cette formation pourront mieux comprendre les terminologies et concepts de la gouvernance numérique mais aussi identifier ses aspects institutionnels, régionaux et internationaux.

Les candidatures féminines et provenant des pays francophones en développement membres de l’OIF ont été fortement encouragées. 30% des fonctionnaires et diplomates sélectionnés sont des femmes et plus de 92% d’entre eux proviennent de pays du Sud en développement.

Dans une dynamique de réplication de cette initiative, d’autres sessions sont prévues en 2024.

Événements à venir :

- Conférence du Réseau francophone des régulateurs des médias – REFRAM (9-10 octobre 2023, Dakar)

- Participation de l’OIF à l’Assemblée générale annuelle de l’ICANN (ICANN 78), Société pour l’attribution des noms de domaines et des numéros sur Internet (21-26 octobre 2023, Hambourg)